NVIDIAJetson AGX Thor专为物理 AI 打造,与上一代产品 NVIDIAJetson AGX Orin 相比,生成式 AI 性能最高提升至 5 倍。通过发布后的软件更新优化,Jetson Thor 的生成式 AI 吞吐量提升至 7 倍。

上一期我们介绍了NVIDIA Jetson AGX Thor 的硬件配置和系统安装教程,本期将深入讲解开发环境配置,包括:

系统环境确认

Docker 安装与配置

JetPack SDK 组件安装

CUDA 环境设置

一、系统环境确认

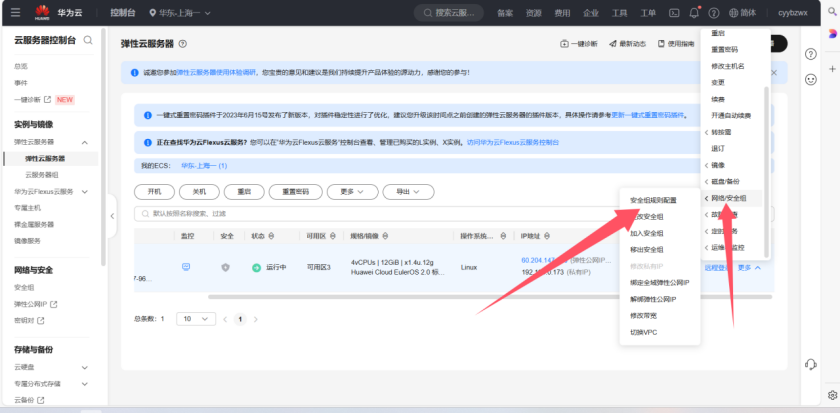

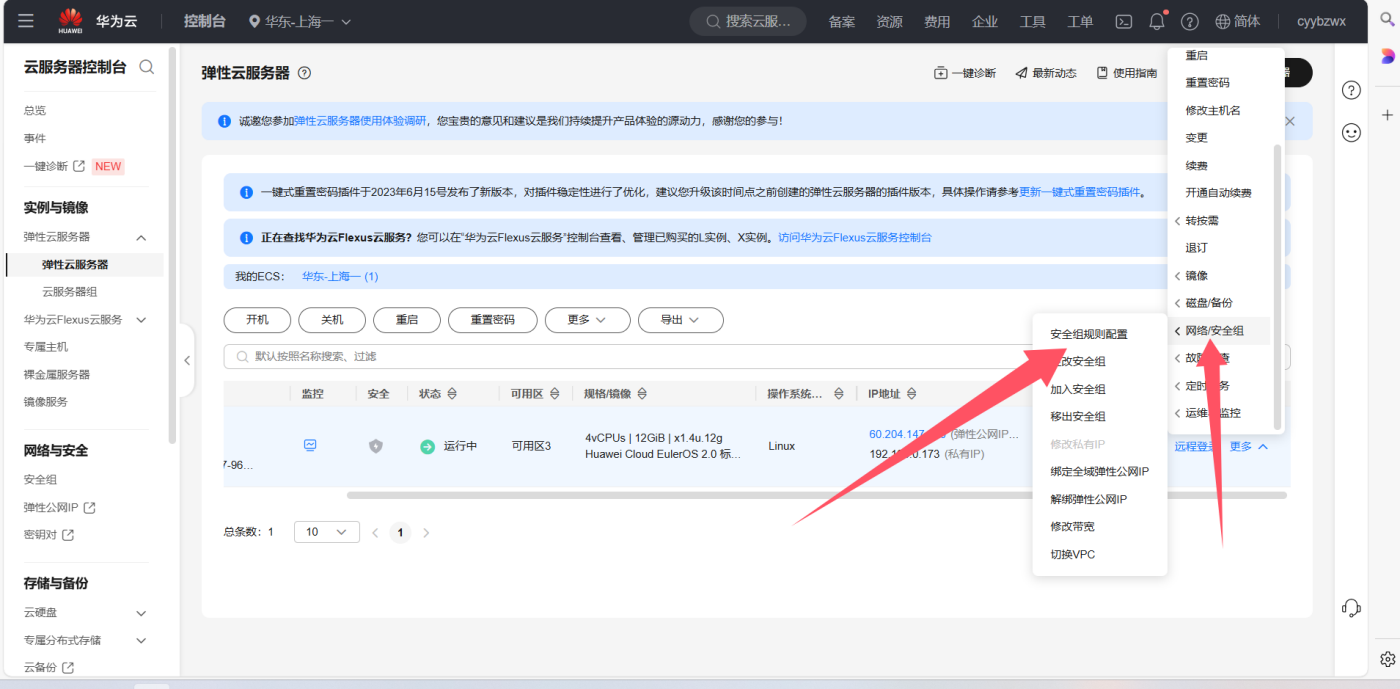

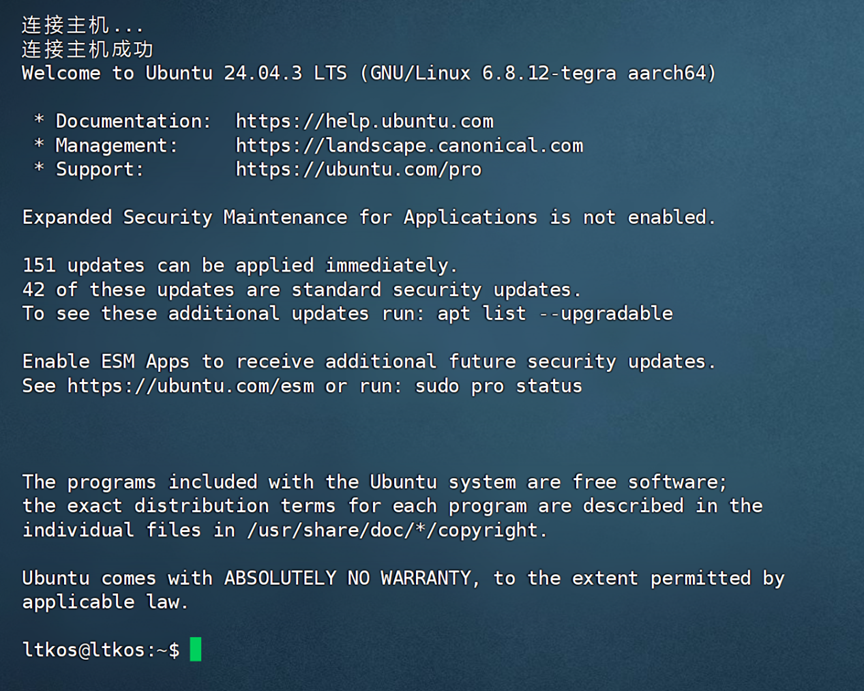

系统安装完成进入桌面后,默认即可通过账号密码 SSH 登录,下图可以查看当前的系统以及内核版本。

- 运行nvidia-smi可以查看 GPU 驱动版本以及支持的 CUDA 最高版本信息。

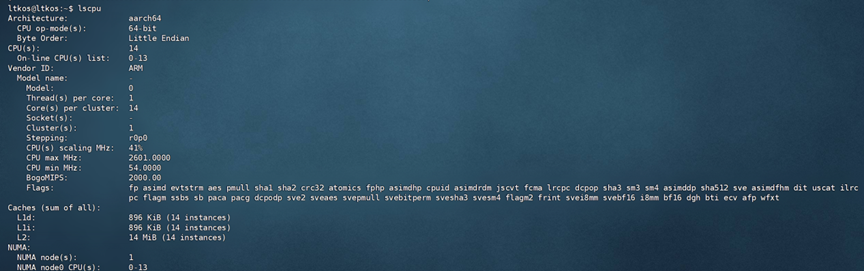

- 运行lscpu,查看 CPU 信息:

- 运行free -h,查看内存容量:

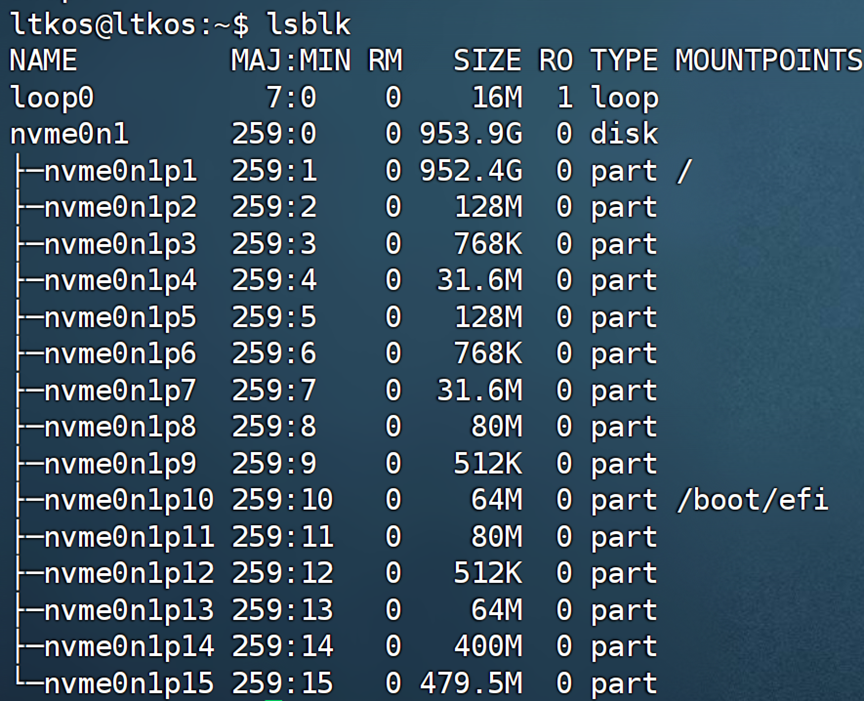

- 运行lsblk,查看硬盘容量:

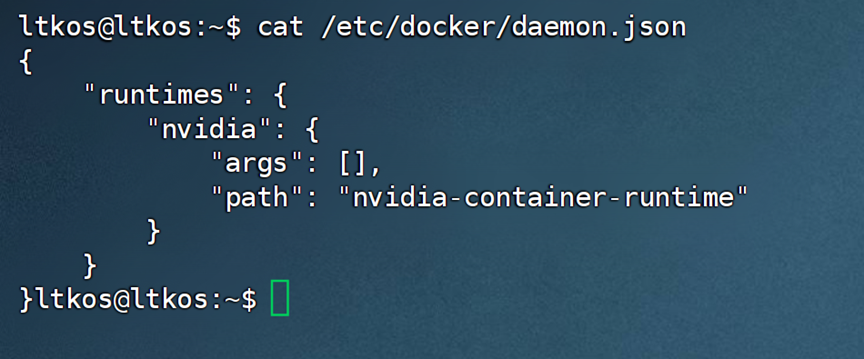

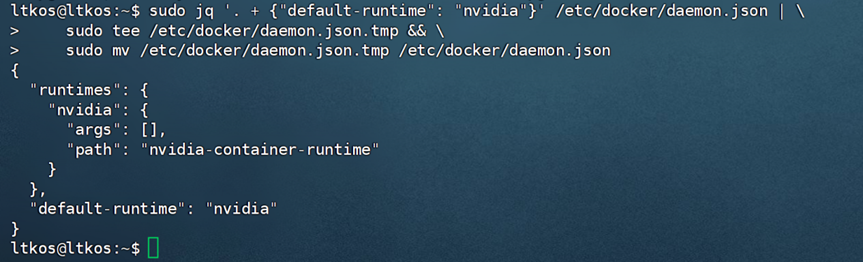

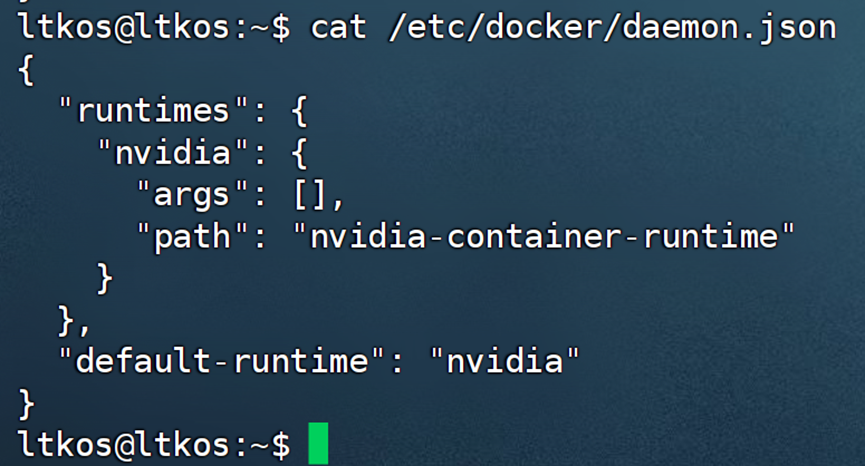

二、Docker 安装与配置

Docker 能够为 Jetson 带来可复现的容器化工作流程,无需牺牲速度或灵活性即可无缝访问 GPU。

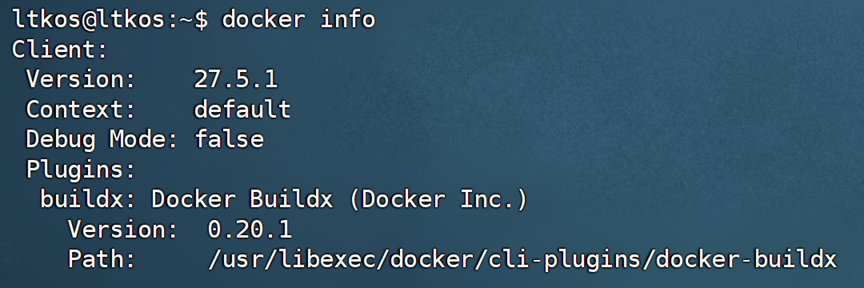

1Docker 安装

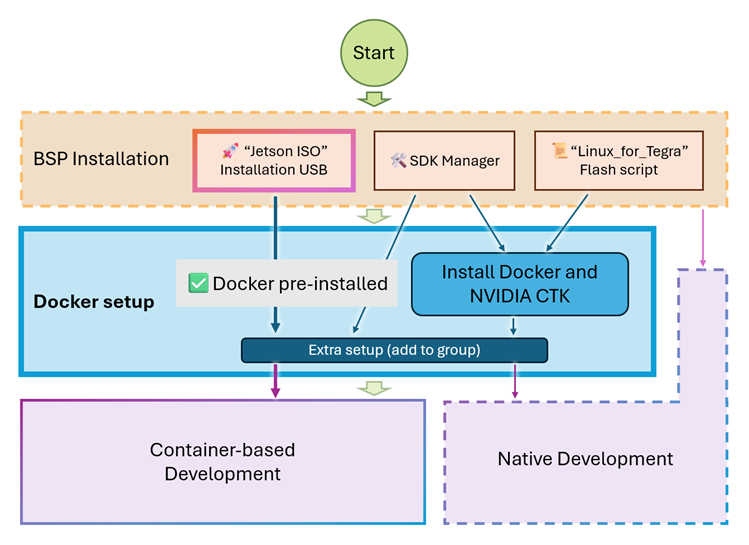

下图展示了 Docker 安装过程的流程。

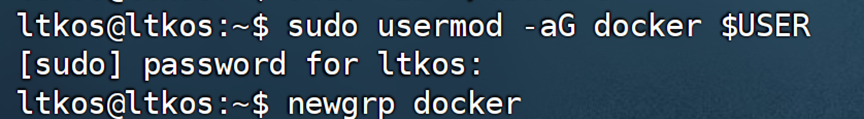

上一期教程采用的是“Jetson ISO Installation USB”系统安装方式,已默认预装 Docker。仅需将普通用户添加到组,即可直接使用 Docker。

然后设置 NVIDIA Container Toolkit 即可。

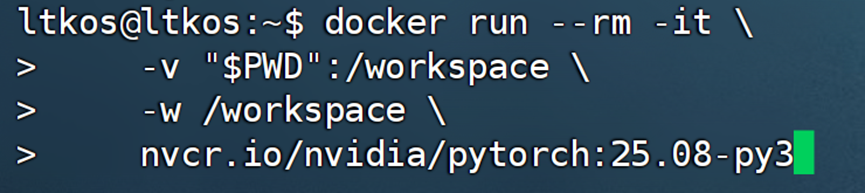

2Docker 测试

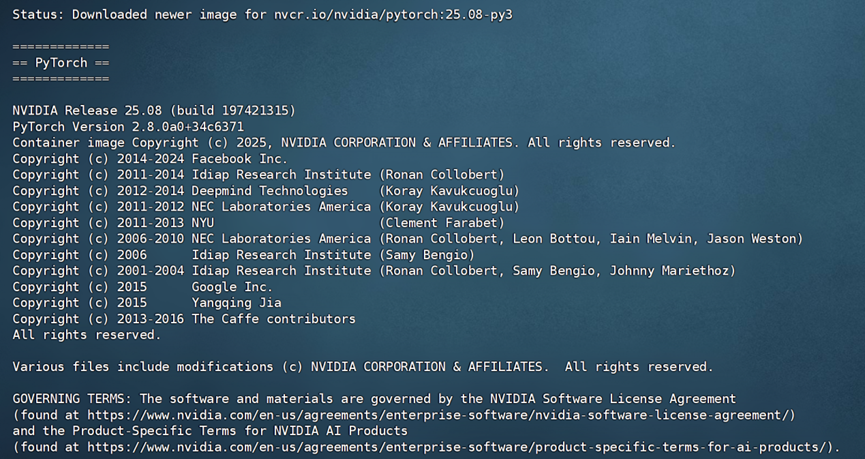

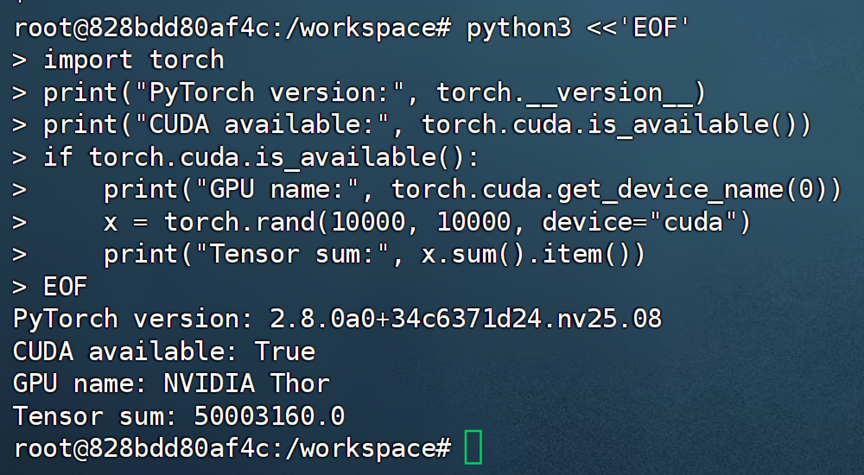

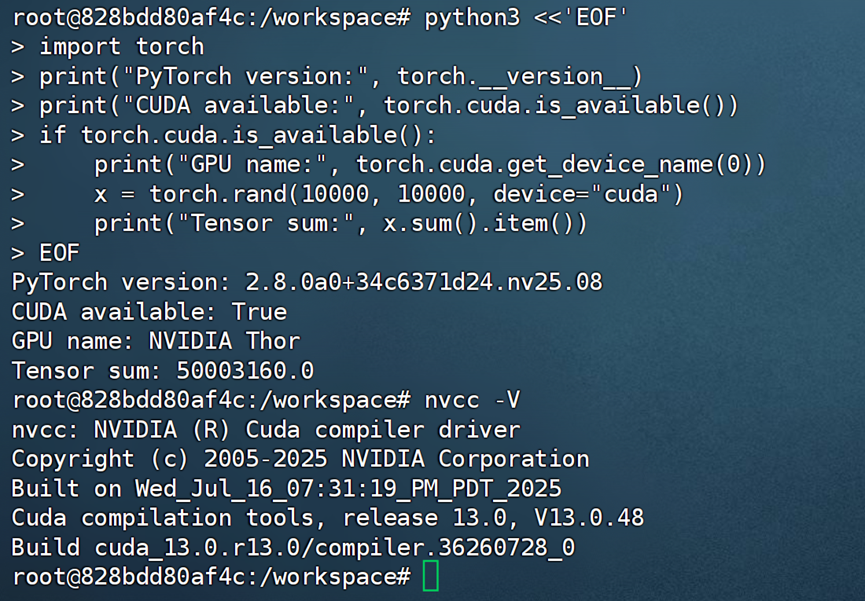

下载并运行一个 PyTorch 的容器。

dockerrun --rm -it -v"$PWD":/workspace -w /workspace nvcr.io/nvidia/pytorch:25.08-py3

进入容器后,您可以测试 PyTorch 的 GPU 功能。此外,该容器内也预配置了 CUDA 环境,可运行相关 CUDA 应用。

注:如果显示 CUDA available:False,可尝试重启系统加载配置。

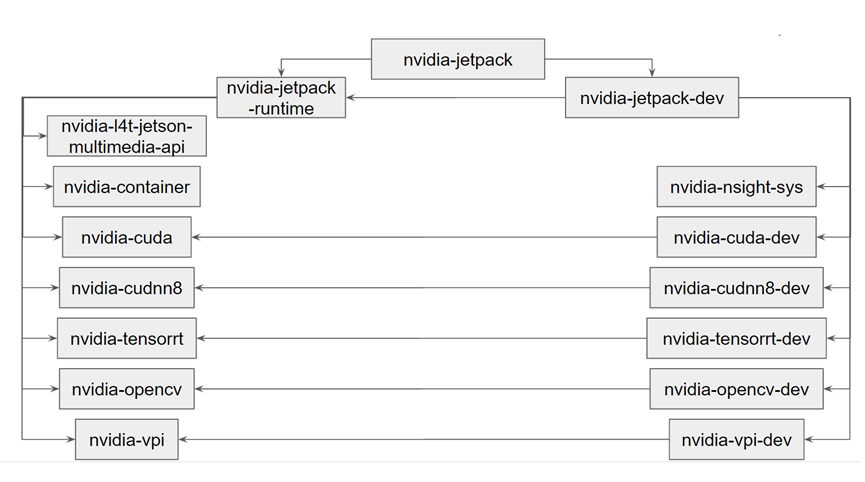

三、JetPack SDK 组件安装

nvidia-jetpack 是一个元包,包含以下组件:

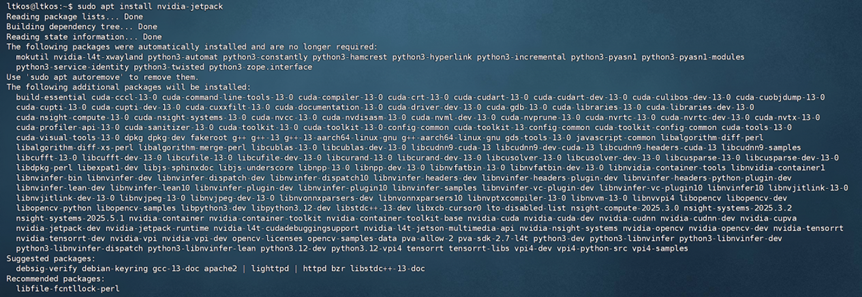

安装 JetPack 组件:

要在 Jetson 上安装完整的 JetPack 组件软件 / SDK,可以使用以下命令:

sudoapt update sudoapt install nvidia-jetpack

等待命令运行完成即可。

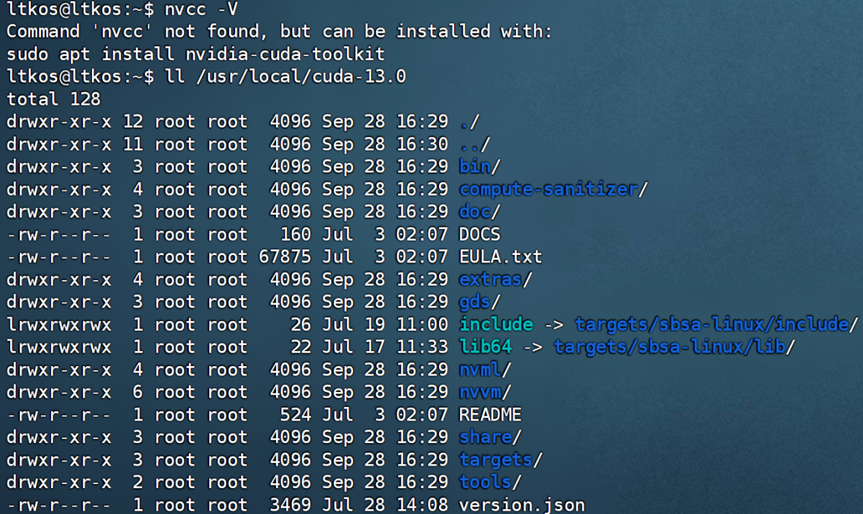

四、CUDA 环境配置

1使用 JetPack 内置的 CUDA

CUDA 工具包已内置于 JetPack 组件中,将随其自动安装。安装完成后,仅需配置环境变量即可使用。

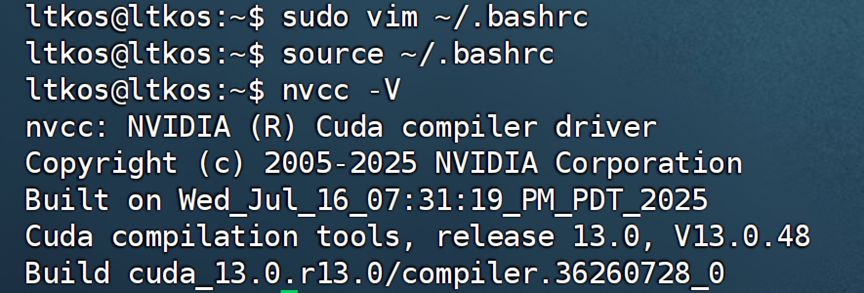

设置并应用环境变量。

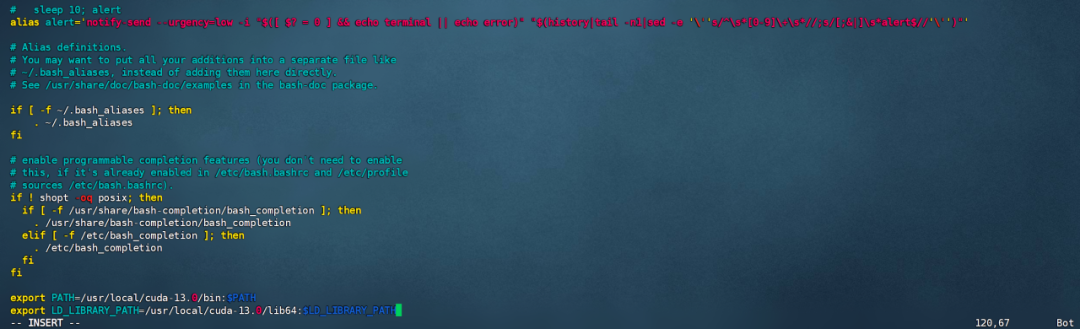

注:运行sudo vim ~/.bashrc之后,需在文本下方加入以下内容:

exportPATH=/usr/local/cuda-13.0/bin:$PATH exportLD_LIBRARY_PATH=/usr/local/cuda-13.0/lib64:$LD_LIBRARY_PATH

2通过 Docker 容器的方式使用 CUDA

本文第二部分 Docker 测试时所下载的nvcr.io/nvidia/pytorch:25.08-py3镜像内已内置 CUDA。

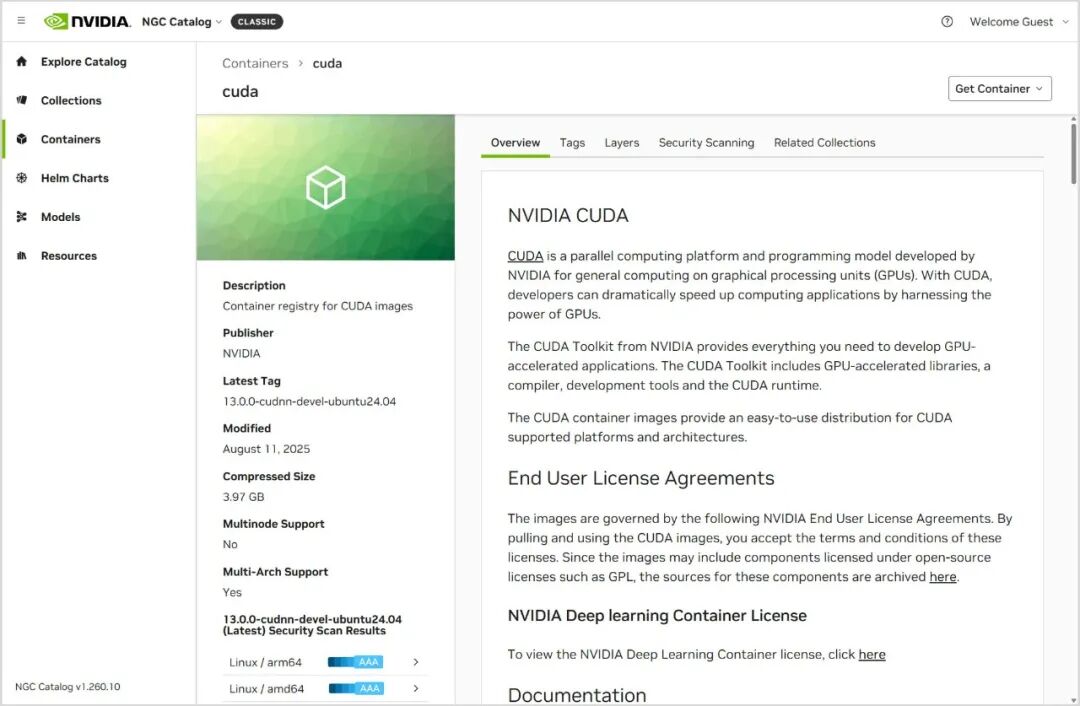

3使用 NGC 下载运行 CUDA 镜像

NGC(全称:NVIDIA GPU Cloud)是适用于 AI、机器学习的 GPU 优化的软件中心,也是 NVIDIA 提供的容器注册表。

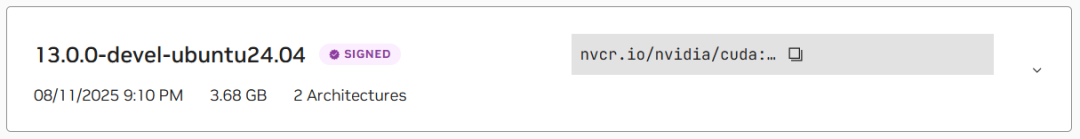

在“标签”部分,您可以看到托管容器的标签列表。

请注意,它显示“2 个架构”。这意味着该容器镜像可同时适用于 x86_64 和 arm64 架构。

您可以单击标签右侧复制图标,将带有该标签的容器图像路径复制到剪贴板,然后使用docker run运行:

dockerrun -it --rm nvcr.io/nvidia/cuda:13.0.0-devel-ubuntu24.04

jetson@jat02-iso0817:~/$ docker run -it --rm nvcr.io/nvidia/cuda:13.0.0-devel-ubuntu24.04 ========== == CUDA == ========== CUDA Version13.0.0 Container image Copyright (c)2016-2023, NVIDIA CORPORATION & AFFILIATES. All rights reserved. This container image and its contents are governedbythe NVIDIA Deep Learning Container License. By pulling and using the container, you accept the terms and conditions ofthislicense: https://developer.nvidia.com/ngc/nvidia-deep-learning-container-license A copy ofthislicenseismade availableinthiscontainer at /NGC-DL-CONTAINER-LICENSEforyour convenience. WARNING: The NVIDIA Driver was not detected. GPU functionality will not be available. Use the NVIDIA Container Toolkit to startthiscontainer with GPU support; see https://docs.nvidia.com/datacenter/cloud-native/ . root@99042c33f4b2:/#

至此,CUDA 环境配置完成!

现在 Jetson AGX Thor Developer Kit 已经准备就绪,您随时可以进行 AI 和边缘计算开发:

使用 Docker 容器化工作流程

基于 JetPack SDK 构建完整应用

利用 CUDA 加速计算任务

*与 NVIDIA 产品相关的图片或视频(完整或部分)的版权均归 NVIDIA Corporation 所有。